29/10/2012

Περί αναξιοπιστίας του κ. Βαξεβάνη

TL;DR

Ο Βαξεβάνης με την δημοσιοποίηση της “λίστας Lagarde” λέει πως ξεμπρόστιασε το σύστημα. Ο εισαγγελέας φαίνεται να θέλει να τον ελέγξει για τις πράξεις του. Δεν θα βρει τίποτα το μεμπτό και όλα καλά. Καθόλου καλά στην πραγματικότητα όμως, ο Βαξεβάνης δεν έκανε κάτι παράνομο, αλλά εκμεταλλεύτηκε την εμπιστοσύνη του κοινού του και έβαλε το προσωπικό του συμφέρον πάνω από όλους.

Ποιος κερδίζει από την δημοσιοποίηση;

Είναι περισσότερο από προφανές ελπίζω για όλους πως ο αρχικός κάτοχος της λίστας που δόθηκε με ανώνυμη επιστολή, κατά τα λεγόμενα του Βαξεβάνη, δεν ήταν κάποιος αδιάφορος. Κάτι ήθελε να πετύχει με αυτό. Θα μπορούσε να είναι ιδεολόγος και να επιζητεί την εξυγίανση της πολιτικής ζωής του τόπου υποκινούμενος από μια αέναη αναζήτηση διαφάνειας, είτε θα μπορούσε απλά να θέλει να βάλει κάποια παραπάνω ευρώ στην τσέπη του. Άλλος λόγος δεν υπάρχει. Έστω πως το έκανε για την διαφάνεια. Τι κερδίσαμε εμείς ως πολίτες με την δημοσιοποίηση κάποιων ονομάτων; Ο ίδιος ο Βαξεβάνης αναφέρει πως δεν είναι σίγουρα παράνομοι όλοι αυτοί στην λίστα. Άρα μάθαμε κάποια ονόματα που ίσως έχουν εμπλακεί σε παράνομες δραστηριότητες. Υπάρχει δηλαδή κάποια υπόνοια πως ίσως αυτοί έχουν παρανομήσει, αλλά δεν το ξέρουμε και σίγουρα. Το αφήνουμε να αιωρείται. Και πάλι, εγώ ως πολίτης τι κερδίζω; Ακόμα και αν υποθέσουμε πως το ΣΔΟΕ είχε επιτέλους αποφασίσει να ελέγξει όλους αυτούς της λίστας ή έστω μιας “έκδοσης” της λίστας που ήδη είναι στα χέρια της εισαγγελίας, για παράνομες δραστηριότητες, τότε ακόμα και ένας καημενίδης που δεν τον είχε πληροφορήσει το “σύστημα” πως είναι μέσα στην λίστα, τώρα πλέον το έχει μάθει. Άρα θα κάνει ό,τι είναι δυνατόν ώστε να κρύψει τις λαμογιές του.

Άρα αν υπήρχε μια ελάχιστη ελπίδα πως το κράτος θα έκανε ελέγχους και θα εισέπραττε έστω και μισό ευρώ από τις παρανομίες κάποιων της λίστας, ο Βαξεβάνης φρόντισε να τους ειδοποιήσει όλους.

Εγώ ως πολίτης έμαθα κάποια ονόματα από τα οποία πλέον είναι αδύνατον να υπάρξει το παραμικρό κέρδος για το κράτος και κατ’ επέκταση για την κοινωνία. Από την άλλη μου κάλυψε μια τεράστια φαγούρα που είχα σχετικά με το ποιοι έχουν βγάλει χρήματα στην Ελβετία άρα έχουν ένα παραπάνω κομπόδεμα. Άντε οι λεύτερες διαβάστε καλά την λίστα και ορμήξτε σε όλους τους εργένηδες που βλέπετε εκεί μέσα. Μόλις η λίστα Lagarde έγινε λίστα γάμου…στην καλύτερη.

Αν τη λίστα την είχε παραδώσει στην εισαγγελία πριν την δώσει ο Βενιζέλος, χωρίς να δημοσιοποιήσει τα ονόματα, τότε θα είχε κάνει κάτι χρήσιμο. Τώρα αυτό που έκανε δεν έχει καμία χρησιμότητα. Μια αμφιβόλου αξίας λίστα υπάρχει ήδη στα χέρια της δικαιοσύνης.

Το μεγάλο λάθος

Ο Βαξεβάνης φρόντισε να βγάλει έκτακτο τεύχος του περιοδικού του με εκτυπωμένα τα ονόματα της λίστας που του παραδόθηκε. Το περιοδικό φυσικά δεν είναι δωρεάν αλλά έχει τιμή πώλησης 2.5€. Ταυτόχρονα ο Βαξεβάνης δεν έχει ανεβάσει την λίστα αυτή στο site του ώστε “να ενημερωθεί ο κόσμος δωρεάν”. Άρα σκοπός του είναι αποκλειστικά η πώληση του περιοδικού και όχι η ενημέρωση του κοινού. Από νωρίς το πρωί του Σαββάτου διάφορα sites έχουν scan-άρει τις σελίδες του περιοδικού και τις έχουν αναρτήσει στις σελίδες τους. Αυτό σημαίνει μείωση πωλήσεων. Έστω πως ο Βαξεβάνης έχει βρει διαστημικά κόλπα και εκτυπώνει το περιοδικό του πάμφθηνα και κερδίζει ακόμα και 1€ από την κάθε πώληση, ποσό εξωπραγματικό για όσους έχουν ασχοληθεί έστω και ελάχιστα με περιοδικά, και έστω πως πούλησε και 100.000 αντίτυπα. Μέγιστο κέρδος 100.000€. Άντε να έκανα λάθος στους υπολογισμούς και να είναι και 150.000€, και 200.000€. Όσο μεγαλύτερο το ποσό τόσο μεγαλύτερο το ατόπημα στην πραγματικότητα. Υπάρχει άνθρωπος που πιστεύει πως ο Βαξεβάνης δεν ήξερε τα μπλεξίματα που θα έχει με την δικαιοσύνη και θα έκανε όλη αυτή την ιστορία για αυτά τα 30 αργύρια από τα οποία θα φάει τα μισά και παραπάνω σε δικηγόρους; Η μήπως κάποιος όντως πιστεύει πως ο ανώνυμος αποστολέας του έδωσε όντως την λίστα χωρίς αντάλλαγμα;

Μας έδωσε μια άχρηστη για εμάς τους πολίτες πληροφορία, την οποία εξαργυρώνει με πωλήσεις, γνωρίζοντας πως θα γίνει φασαρία για το θέμα. Και φυσικά θα γίνει και ντόρος γύρω από το όνομά του.

Αν ο Βαξεβάνης ήθελε να ενημερώσει απλά το κοινό είχε 1002 τρόπους να το κάνει εντελώς δωρεάν και γι’ αυτόν και για όλους μας. Αντιθέτως επέλεξε τον μοναδικό κατά τον οποίο ο μόνος που έχει όφελος είναι ο δικός του τραπεζικός λογαριασμός. Άραγε είναι στην Ελβετία ο δικός του; μμμμ…

Ο “χαμένος” πληροφοριοδότης

Ο κάθε δημοσιογράφος που κάνει έρευνα έχει τους πληροφοριοδότες του. Αυτούς τους κρατάει με νύχια και με δόντια να μην τους χάσει. Αυτοί του δίνουν δουλειά, αυτός τους το ξεπληρώνει. Όπως μπορεί. Αν ήσασταν εσείς ο πληροφοριοδότης του Βαξεβάνη και του δίνατε την λίστα δωρεάν, θα σας άρεσε να βγάλει ο Βαξεβάνης χρήματα, είπαμε το περιοδικό δεν είναι τζάμπα, με τον δικό σας κόπο χωρίς να βγάλετε το παραμικρό κέρδος; Προφανώς όχι. Δεν θα του ξαναδίνατε τίποτα. Και ο Βαξεβάνης δεν είναι τόσο χαζός να χάσει ένα τέτοιο πληροφοριοδότη που έχει άκρες να του δίνει τέτοια “σημαντικά” στοιχεία. Άρα όχι απλά βρωμάει η ιστορία, αλλά το παραμύθι με τον “ανώνυμο αποστολέα” είναι πιο γελοίο από οτιδήποτε άλλο. Πρέπει η σκέψη σου να είναι πραγματικά παιδική ακόμα για να πιστέψεις πως κάποιος “ανώνυμος” χάρισε την λίστα και δεν την πούλησε. Δεν είναι και λίγοι αυτοί που την έψαχναν για να την βγάλουν στον αέρα…με το αζημίωτο φυσικά. Άρα ας σκεφτούμε τα κίνητρα του πληροφοριοδότη λίγο παραπάνω. Και έπειτα τα κίνητρα του “μεταφορέα” της πληροφορίας…

wikileaks.gr ή μήπως όχι;

Κάποιοι συγκρίνουν το wikileaks με αυτό που έκανε ο Βαξεβάνης. Μα πάτε καλά; #FreeVaxevanis; Από που και ως που; Ο Βαξεβάνης είπε ξεκάθαρα, δώσε μου 2.5€ αν θες να μάθεις τα ονόματα. Αυτό δεν έχει γίνει ποτέ από το wikileaks και μην μιλήσει κανείς για το κόστος της “πληροφορίας”. Προφανώς το κόστος λειτουργίας των 2 “οργανισμών” είναι χαοτικά διαφορετικό. Επίσης, δωρεάν δεν είπε πως το πήρε το USB από τον ανώνυμο αποστολέα; Τι συζητάμε για κόστος;

Ας μην ξεχνάμε επίσης πως το wikileaks ασχολείται κυρίως με κρατικά και στρατιωτικά μυστικά και λιγότερο έως ελάχιστα με συναλλαγές ιδιωτών, που μπορεί μάλιστα και να είναι αθώοι…Ο Βαξεβάνης δεν έβγαλε κάποια πληροφορία που να δείχνει πως κάποιος συγκεκριμένος κρατικός λειτουργός δεν έκανε τη δουλειά του σωστά. Για την ακρίβεια ο Βαξεβάνης δεν έκανε καμία δημοσιογραφική έρευνα στο συγκεκριμένο θέμα. Του δόθηκε μια λίστα, την επεξεργάστηκε και την δημοσίευσε. Ούτε έρευνα ούτε τίποτε άλλο.

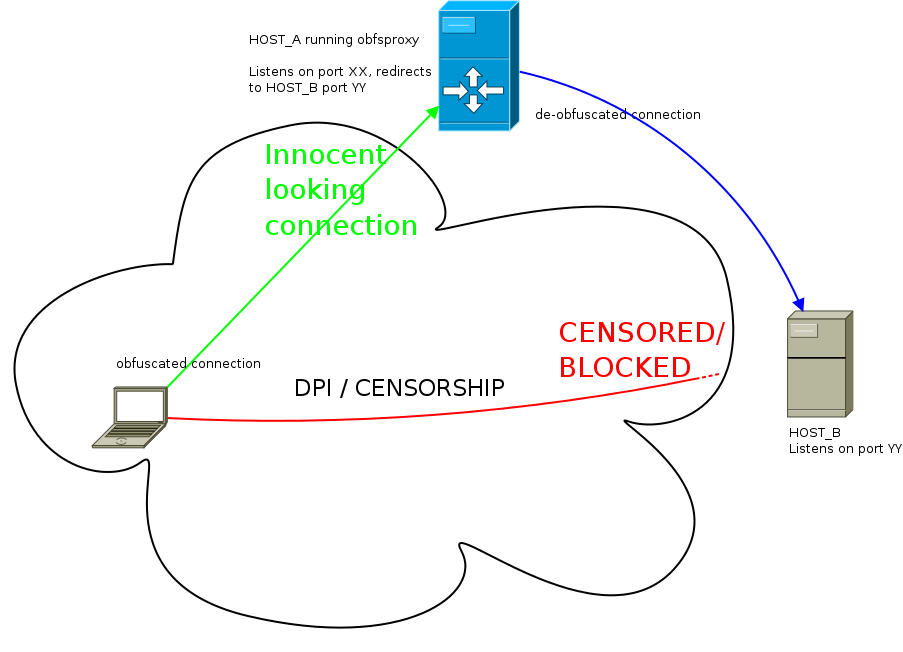

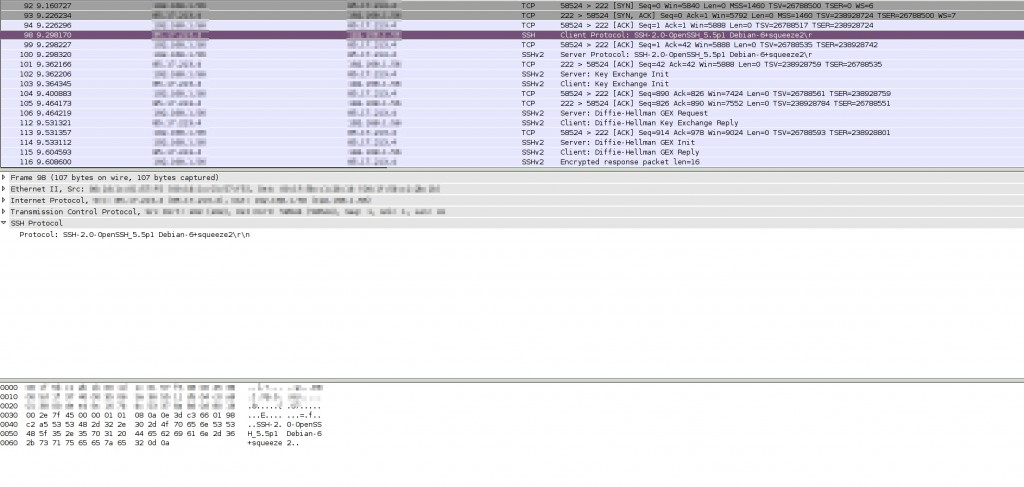

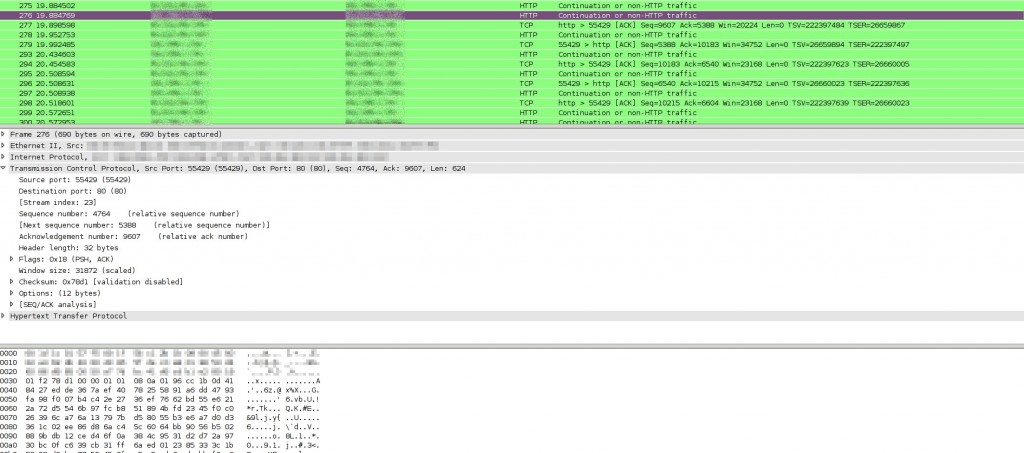

Αν ο Βαξεβάνης και ο κάθε δημοσιογράφος, πολιτικός, μέλος μιας πολιτικής ομάδας, ακτιβιστής, κτλ θέλει να βγάλει δημόσια και ανώνυμα μια πληροφορία, αυτό είναι απόλυτα εφικτό με την σημερινή τεχνολογία. Αν δεν ξέρει το πως, ας έρθει στο cryptoparty που θα κάνουμε σε λίγες μέρες στην Αθήνα και θα το μάθει…Αν όμως θέλει να κάνει μόστρα και όχι απλά να “ενημερώσει” το κοινό…ε τότε δεν του φταίει κανείς.

Είναι τα ονόματα αυτά τα αρχικά ονόματα της λίστα Lagarde;

Άντε και όντως βρίσκει ο Βαξεβάνης μια δικαιολογία για τον λόγο που δημοσιοποίησε την λίστα, ποιος διασφαλίζει πως τα ονόματα δεν έχουν υποστεί επεξεργασία; Βασιζόμαστε στον λόγο και την τιμή του Βαξεβάνη. Ή μάλλον στον “ανώνυμο αποστολέα” και στον Βαξεβάνη. Ή καλύτερα σε αυτόν που το έδωσε στον ανώνυμο αποστολέα και πάει λέγοντας. Η λίστα μπορεί να έχει μεταβληθεί από τον κάθε ενδιάμεσο, είτε προσθέτοντας είτε αφαιρώντας ονόματα. Και φυσικά μια τέτοια προσθαφαίρεση κάτι δεν θα κοστίζει; Ο βράχος της δημοσιογραφίας γιατί δεν έδωσε την λίστα σε ειδικούς για να μελετήσουν το USB και το αρχείο για να εντοπίσουν αν έχει υποστεί επεξεργασία; Επίσης πιστεύει κανείς πως αν κάποιος είχε παράνομα εξάγει χρήματα θα το έκανε με το ονοματεπώνυμό του και όχι ξεπλένωντάς τα μέσω 15 offshore; Δηλαδή πόσο χαζός μπορεί να είναι κανείς; Εντάξει όχι χαζός, αθώος…ή απλά τηλεθεατής.

Έρευνα; Αυτός ο άγνωστος

Ναι, έρευνα! Έρευνα θα ήταν να μελετούσε το αρχείο με ειδικούς και να μας ενημέρωνε πως κάποια ονόματα έχουν διαγραφεί ή προστεθεί στην αρχική λίστα. Ναι, θα μπορούσε να γίνει κάτι τέτοιο (υπό συνθήκες). Έρευνα θα ήταν να κατάφερνε να βρει ποιος από το γραφείο του Χ υπουργού “έχασε” το αρχείο. Έρευνα θα ήταν πολλά άλλα πράγματα, αλλά όχι αυτό που έκανε.

Ε και τι να έκανε ο Βαξεβάνης;

Έστω πως ξυπνάς μια μέρα και βρίσκεις στην πόρτα σου την λίστα Lagarde. Τι θα έκανες; Για αρχή θα έκανες κάποια αντίγραφα ασφαλείας και θα τα έστελνες στα πέρατα της γης..ας είναι καλά το “cloud” (έτσι για να προσθέτουμε και buzzwords στο post). Έπειτα θα μπορούσες να πας στον εισαγγελέα και να του πεις: “ωπ κοίτα τι βρήκα στην πόρτα μου, έχει το συγκεκριμένο αρχείο τα ίδια ονόματα με αυτά που σου έδωσε ο Σαμαράς/Benny;” Ταυτόχρονα ανακοινώνεις στο κοινό πως παρέδωσες και εσύ μια λίστα, πως έχεις αντίγραφο/α από αυτήν φυσικά, και αφήνεις πλέον τον κόσμο να πιέζει τους πολιτικούς και την δικαιοσύνη να βγάλουν άκρη όσο το δυνατόν πιο γρήγορα. Μη μου πεις πως πιστεύεις πως η λίστα που έδωσε ο Βενιζέλος στον Σαμαρά δεν έχει υποστεί επεξεργασία…αν ο πληροφοριοδότης σου είναι καλός ίσως έχει αντίγραφο της λίστας προτού την πάρει ο Βενιζέλος ή ο Παπακωνσταντίνου ή ο Διώτης ή ή ή…εκτός και αν είσαι σίγουρος πως είναι ίδια η λίστα. Αλλά πως μπορεί να είσαι σίγουρος εσύ ως δημοσιογράφος αφού υποτίθεται δεν έχεις δει την λίστα που έχει ο εισαγγελέας στα χέρια του; Εκτός αν σου είπαν πως είναι η ίδια με του εισαγγελέα, αλλά τότε δεν μπαίνεις στην διαδικασία να αναρωτηθείς ως δημοσιογράφος, “ρε μπας και έχει υποστεί αλλαγή η λίστα και δεν είναι η αυθεντική; μπας και έχει λάθος στοιχεία μέσα; Πώς μπορώ να είμαι σίγουρος για τα περιεχόμενό της;” Όχι ε;

Αν υποθέσουμε πως το σάπιο πολιτικό σύστημα είναι ένας παλαιστής του Sumo, είναι εντελώς ηλίθιο να κατέβω εγώ να το πολεμήσω σε ένα γήπεδο του Sumo. Αν θέλω να νικήσω τον παλαιστή θα τον αναγκάσω να έρθει σε αγώνα ταχύτητας μαζί μου. Εκεί θα χάσει. Ο Βαξεβάνης επέλεξε να παίξει Sumo με το σύστημα. Επιλογή του. Αλλά είναι δεδομένο πως θα χάσει. Και δεν μπορεί να είναι τόσο χαζός και να μην το ξέρει πως θα χάσει.

Εκτός και αν…

Εκτός και αν την λίστα την έδωσε το ίδιο το σύστημα. Κράτος ή παρακράτος, μικρή διαφορά έχει. Μια λίστα επεξεργασμένη, με μηδαμινό αντίκτυπο και κόστος για το πολιτικό σύστημα πια. Ελάχιστοι πολιτικοί αναφέρονται μέσα στα ονόματα της λίστας, άρα “το πολιτικό σύστημα βγήκε καθαρό”. Λάθος, το έβγαλε καθαρό. Μάλιστα οι καλοί μας οι πολιτικοί παρέδωσαν την λίστα και στον εισαγγελέα για “περαιτέρω έρευνα”. Το ΣΔΟΕ δεν έκανε καλά την δουλειά του λοιπόν…α και εσύ Βαξεβάνη μόλις φρόντισες να μην μπορέσει σε καμία περίπτωση να την κάνει. Όλοι χαρούμενοι. Κοινώς μόλις εσύ ο αντι-συστημικός έγινες το καλύτερα γυαλισμένο γρανάζι του συστήματος. Και δεν είσαι χαζός για να το κάνεις χωρίς κάποιο κέρδος…

Μα δες που έχει μπλέξει τώρα! Τι είναι αυτά που λες;;

Ναι, τον κυνηγάει ο εισαγγελέας! Για μια λίστα που αναφέρει μόνο ονόματα και όχι άλλα στοιχεία. Τα ονόματα δεν είναι ευαίσθητα προσωπικά δεδομένα από μόνα τους, είναι απλά προσωπικά δεδομένα. Και αυτός ο καημένος απλά πήρε ένα ανώνυμο tip, και έβαλε και disclaimer πως δεν είναι σίγουρος πως είναι παράνομοι όλοι αυτοί! Δεν θα διωχθεί ούτε για δημοσιοποίηση ευαίσθητων προσωπικών δεδομένων ούτε για υποκλοπή δεδομένων από κάποια υπηρεσία. Όλα μέλι γάλα. [1]

“Μα που είναι η ελευθεροτυπία και η ελευθερία του λόγου σε αυτή τη χώρα” αναρωτιούνται όλοι στο twitter και στα υπόλοιπα “social media”. Συγχαρητήρια, μόλις πετάξατε την μπάλα έξω από το γήπεδο. Ο Βαξεβάνης λέει, πως γίνεται να με κατηγορείτε εμένα γι’ αυτό που έκανα και που δεν είναι καν πταίσμα, ενώ εσείς οι πολιτικοί έχετε κάνει τόσα και τόσα. Μα καλέ μου Βαξεβάνη, είναι δυνατόν να ζητάς από την “ανεξάρτητη δικαιοσύνη” να βγεις λάδι και να μην γίνει ούτε καν έρευνα, βασιζόμενος στο γεγονός πως κάποιος άλλος την έβγαλε και αυτός λάδι; Αυτό μας οδηγεί σε ένα ατέρμονο loop…”Μη με κατηγορείτε εμένα γιατί ξέρω και άλλους βρωμιάρηδες που έχουν βγει λάδι.” Δηλαδή επειδή το σύστημα, το οποίο εσύ καταγγέλεις ως σάπιο, αθωώνει κάποιους άλλους, ζητάς να έχεις και εσύ την ίδια μεταχείριση. Αν αυτοί που βγαίνουν λάδι είναι λαμόγια, εσύ τι ζητάς; Να γίνεις και εσύ ένα από αυτά;

Είναι δυνατόν κ. δημοσιογράφε να πιστεύεις πως θα παίξεις με τους κανόνες του συστήματος για να ρίξεις το σύστημα; Δεν είσαι τόσο χαζός. Δεν γίνεται να είσαι τόσο χαζός. Κάτι άλλο συμβαίνει.

Από την Αυριανή στον Βαξεβάνη

Η κάθε εποχή έχει τους δικούς της “δημοσιογράφους” που υποτίθεται δουλεύουν κόντρα στο σύστημα. Πριν καμιά 15-20 χρόνια ήταν η Αυριανή και ο πανίσχυρος τότε Κουρής, μετά μπλέχτηκε και αυτός με το σύστημα και τον έφαγε η μαρμάγκα. Έπειτα ήρθε ο Μάκης με τις καταγγελίες του ενάντια σε όλους και όλα. Η διαφάνεια είχε επιτέλους βρει τον υπερ-ηρωά της. Ξημεροβραδιάζοταν κόσμος βλέποντας να ξεμπροστιάζονται άνθρωποι στις εκπομπές του, κανείς δεν τον σταματούσε. Και τελικά; Τι έγινε με όλες αυτές τις περιπτώσεις; Ξεκαθάρισε κάτι; Έφτιαξε το σύστημα ή μήπως χώθηκαν όλοι λίγο παραπάνω στο βούρκο; Και σιγά σιγά το σύστημα τον κατανάλωσε και είναι και αυτός πλέον στο περιθώριο. Έπειτα ήρθε ο τρωκτικός-Γκόλιας. Μια από τα ίδια, μέχρι που αυτόν όντως τον έφαγε η μαρμάγκα. Σήμερα είναι ο Βαξεβάνης. Σε ακριβώς τον ίδιο ρόλο με τους προηγούμενους. Ο κατατρεγμένος μαχητικός δημοσιογράφος που πολεμάει το σύστημα. Μια λεπτομέρεια μόνο, το σύστημα δεν θα πέσει από κάποιους που συνδιαλέγονται και συναλλάσσονται μαζί του. Αυτοί είναι μέρος του. Το ταΐζουν και τους ταΐζει.

Αυτή τη βδομάδα στις μικρές σας οθόνες

Δεν θέλει καθόλου φαντασία για να δούμε τι θα γίνει από Δευτέρα. Οι μισοί “έγκριτοι” δημοσιογράφοι θα κυνηγάνε το θέμα της ημέρας: “Τι περιέχει η λίστα του Βαξεβάνη”. Οι άλλοι θα ασχολούνται με το “ποιος είναι τελικά ο τάδε καραβοκύρης που έχει βγάλει τόσα λεφτά στην Ελβετία;” Ψιτ, οι καραβοκύρηδες δεν πληρώνουν φόρους σύμφωνα με νόμο του κράτους..όσα λεφτά και να έχει βγάλει στην Ελβετία κατά 99.99999999% είναι νομιμότατα. Το Star θα ασχολείται με το που πήγαν διακοπές οι celebrities της λίστας και ο λαός θα αποχαυνώνεται μπροστά στο χαζοκούτι. Α, και εντελώς τυχαία αυτή τη βδομάδα έχουμε να περάσουμε και κάτι μέτρα μωρέ από την Βουλή, δεν ξέρω αν το θυμάστε ακόμα. Το ξεχάσατε ε; Ώρε δες συμπτώσεις…έκτακτο τεύχος…για έκτακτες ανάγκες.

Και άλλες λίστες;

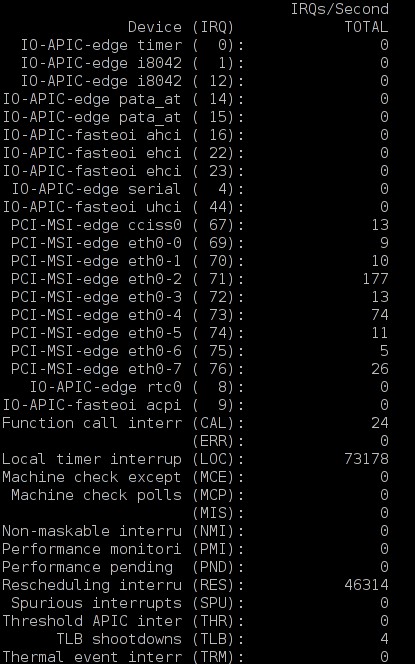

Ε ναι λοιπόν το παραδέχομαι. Έχω και εγώ στα χέρια μου την λίστα Lagarde και όχι μόνο όμως. Έχω άλλη μια λίστα που δεν έχει κυκλοφορήσει ακόμα και έχει λογαριασμούς από μια άλλη ελβετική τράπεζα, την UBS. Για να μην ξεφύγουν όλα τα ονόματα έχω φτιάξει ένα σύστημα [2] με το οποίο θα βλέπετε το πολύ 30 ονόματα τη φορά. Φτάνουν. Και σας τα δίνω και τζάμπα…

Όσο έμπιστη είναι η λίστα του Βαξεβάνη τόσο έμπιστη είναι και η δική μου λίστα. Και όσες άλλες λίστες παρουσιαστούν.

Και για όποιον δεν το έπιασε (να το κοιτάξει) οι παραπάνω “λίστες” δίνουν απλά τυχαία ονόματα. Μπορεί κάποιος να φτιάξει μια λίστα με τους καλύτερους μάγειρες της Αθήνας ή αυτούς που πουλάνε σκυλάκια με μία βούλα στην πλάτη, κτλ, κτλ.

Τέλος, φτάνει

Αν έχουμε φτάσει να βασίζουμε την ελευθερία μας πάνω σε ένα και μόνο δημοσιογράφο που υποτίθεται πως κάνει έρευνα με τέτοιο τρόπο τότε είμαστε άξιοι της μοίρας μας. Δουλειά των δημοσιογράφων αλλά και των πολιτών είναι να ελέγχουν το πολιτικό σύστημα. Και εδώ πρέπει ο καθένας μας να αναλάβει τις ευθύνες του και να μην μεταβιβάζει τις όποιες ελπίδες του για διαλεύκανση στον Βαξεβάνη και στον κάθε μελλοντικό Βαξεβάνη. Είμαστε όλοι συνυπεύθυνοι.

Δεν μου αρκεί ο Βαξεβάνης και ο κάθε Βαξεβάνης να έχει βγάλει 5 σωστές ειδήσεις και να είναι καλύτερος από τους υπόλοιπους δημοσιογράφους. Όχι, έχω πολύ υψηλότερα standards. Θέλω να είναι πάντα καλός και να κάνει πάντα σωστά την δουλειά του. Και τώρα έκανε ένα πάρα πολύ μεγάλο λάθος. Έβγαλε μια αδιάφορη για τον κόσμο είδηση, η οποία ήξερε πως θα προκαλέσει αντιδράσεις, ώστε να εκμεταλλευτεί την εύνοια του κόσμου και να κάνει ντόρο γύρω από το όνομά του. Στα δικά μου μάτια είναι πλέον πλήρως αναξιόπιστος.

[1] και τελικά αυτό ΑΚΡΙΒΩΣ ισχυρίστηκε ο Βαξεβάνης: http://news.in.gr/greece/article/?aid=1231219599 Πρέπει να γίνω προφήτης τελικά…

[2] Όποιος θέλει να δει πως δουλεύει το σύστημα αρκεί να ανοίξει το παρακάτω αρχείο: http://83.212.100.216/make_a_list.txt

Filed by kargig at 10:08 under General,Greek

Filed by kargig at 10:08 under General,Greek

Tags: Lagarde, Βαξεβάνης, δημοσιογραφία, λίστα

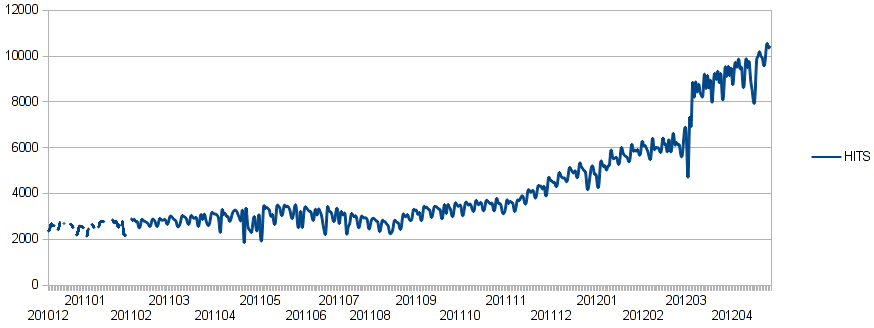

13 Comments | 18,152 views

13 Comments | 18,152 views